El Reglamento Europeo sobre IA, tiene como objetivo encontrar un punto de equilibrio a la hora de fomentar el desarrollo y la implantación responsable de esta herramienta. Dicho reglamento, entró en vigor el pasado 1 de agosto en la UE, pero es a partir de este domingo 2 de febrero cuando son determinantes sus primeras prohibiciones a ciertos procedimientos, según el nivel de su clasificación intrínseca que consta de cuatro puntos críticos basados en el riesgo. Las empresas se enfrentarán a multas de hasta 35 millones de euros, o de un 7 % de su cifra anual de negocio, si incumplen el Reglamento europeo de Inteligencia Artificial (IA) según la Agencia EFE. Las normas imponen obligaciones a los proveedores y los responsables del despliegue de tecnologías de IA y regulan la autorización de los sistemas de inteligencia artificial en el mercado único de la UE.

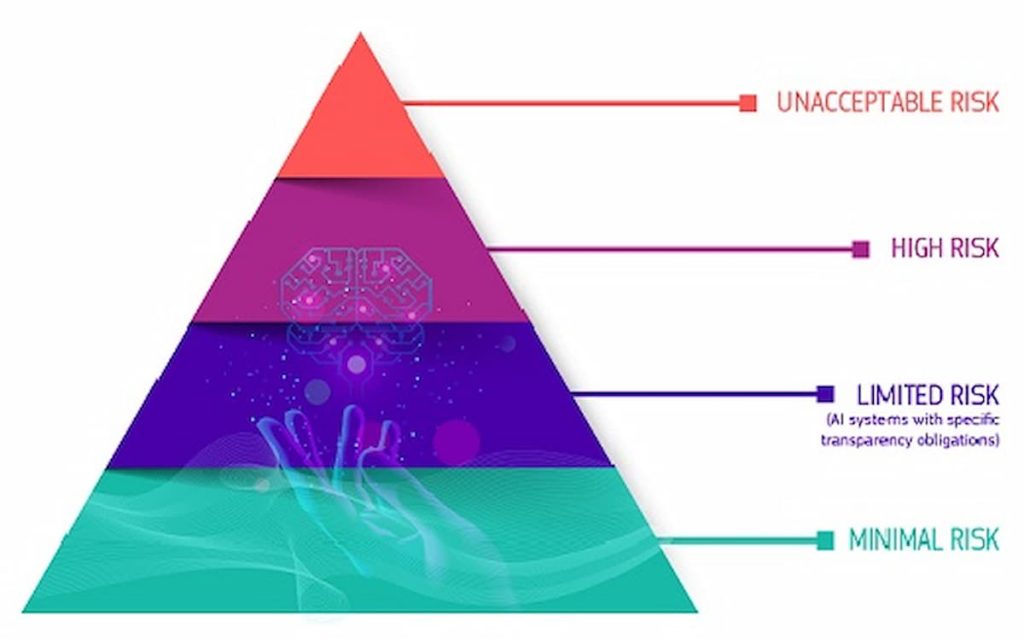

Los cuatro niveles del Reglamento Europeo de IA

El Reglamento de Inteligencia Artificial de la Unión Europea (RIA) establece un marco normativo que clasifica los sistemas de IA en cuatro niveles de riesgo, con el objetivo de garantizar la seguridad, la transparencia y el respeto a los derechos fundamentales. A continuación, se detallan estos niveles:

1. Riesgo Inaceptable

Esta categoría incluye sistemas de IA que representan una amenaza clara para la seguridad, los derechos fundamentales o los valores de la Unión Europea y, por lo tanto, están prohibidos. Ejemplos de estos sistemas son:

- Manipulación del comportamiento humano: Sistemas que emplean técnicas subliminales o engañosas para influir en las decisiones de las personas, mermando su capacidad de decidir informadamente.

- Explotación de vulnerabilidades: IA que se aprovecha de las vulnerabilidades de grupos específicos, como niños o personas con discapacidades, para distorsionar su comportamiento.

- Sistemas de puntuación social: Aquellos que evalúan y clasifican a las personas en función de su comportamiento social o características personales, lo que puede llevar a discriminación y estigmatización.

- Reconocimiento biométrico en tiempo real en espacios públicos: El uso de sistemas de reconocimiento facial en tiempo real en lugares públicos para fines de aplicación de la ley está prohibido, salvo en situaciones excepcionales y bajo estrictas condiciones.

2. Alto Riesgo

Los sistemas de IA clasificados como de alto riesgo son aquellos que, aunque ofrecen beneficios significativos, también pueden tener un impacto considerable en los derechos fundamentales, la seguridad o la salud de las personas. Estos sistemas están sujetos a estrictos requisitos antes de su despliegue y durante su uso. Ejemplos incluyen:

- Infraestructuras críticas: Sistemas de IA que gestionan infraestructuras esenciales, como redes eléctricas o suministro de agua, donde un fallo podría tener consecuencias catastróficas.

- Educación y formación profesional: IA utilizada para evaluar el rendimiento de estudiantes o candidatos, lo que puede influir en su trayectoria educativa y profesional.

- Empleo y gestión de trabajadores: Sistemas que asisten en la contratación, promoción o despido de empleados, afectando directamente sus oportunidades laborales.

- Servicios esenciales privados y públicos: IA que determina el acceso a servicios fundamentales, como préstamos bancarios, seguros o asistencia social.

- Aplicación de la ley y gestión de la migración: Sistemas utilizados en la identificación de personas, evaluación de riesgos o decisiones relacionadas con la inmigración y el asilo.

- Administración de justicia: IA empleada en procesos judiciales, como la evaluación de pruebas o la predicción de sentencias.

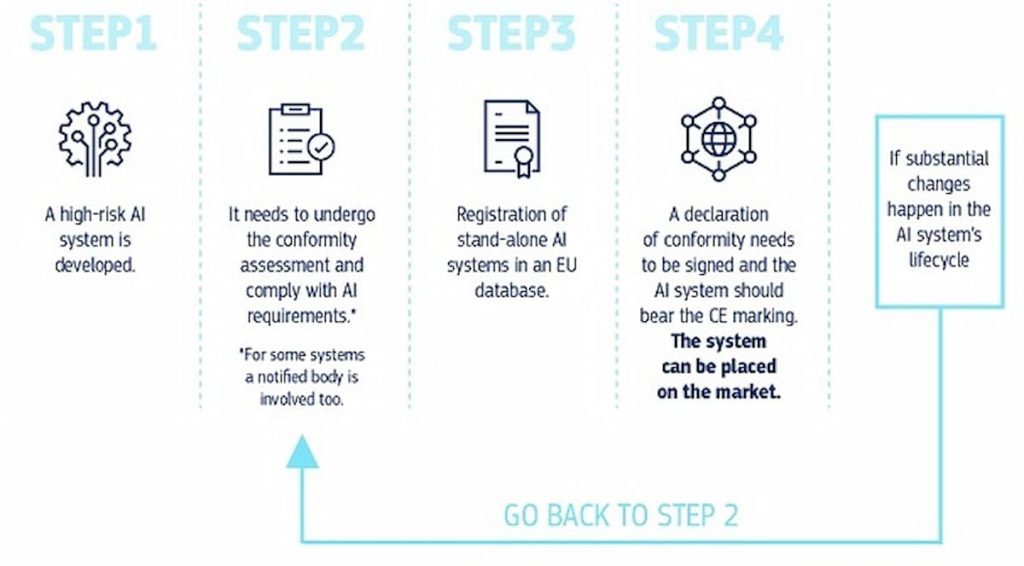

Los proveedores de estos sistemas deben cumplir con obligaciones como:

- Gestión de riesgos: Implementar procesos para identificar, evaluar y mitigar riesgos asociados al sistema de IA.

- Gobernanza de datos: Asegurar la calidad, integridad y seguridad de los datos utilizados, evitando sesgos y garantizando la privacidad.

- Documentación técnica y registro: Mantener una documentación detallada que permita la trazabilidad del sistema y facilite su auditoría.

- Transparencia y provisión de información: Proporcionar información clara y comprensible sobre el funcionamiento del sistema y sus decisiones.

- Supervisión humana: Garantizar que las decisiones críticas puedan ser revisadas o anuladas por humanos, evitando una dependencia total de la IA.

- Robustez, precisión y ciberseguridad: Asegurar que el sistema funcione de manera fiable, con un margen mínimo de error, y esté protegido contra ciberataques.

3. Riesgo Limitado

Esta categoría abarca sistemas de IA que interactúan directamente con los usuarios y pueden influir en sus decisiones o comportamientos, pero cuyo impacto potencial es menor en comparación con los sistemas de alto riesgo. Aunque no están sujetos a las estrictas obligaciones de los sistemas de alto riesgo, deben cumplir con ciertos requisitos de transparencia. Ejemplos incluyen:

- Chatbots y asistentes virtuales: Sistemas que interactúan con los usuarios, proporcionando información o asistencia.

- Filtros de contenido: IA que selecciona o modera contenido en plataformas digitales, como recomendaciones de videos o moderación de comentarios.

Las obligaciones para estos sistemas se centran en:

- Transparencia: Informar claramente a los usuarios de que están interactuando con un sistema de IA, permitiéndoles tomar decisiones informadas.

4. Riesgo Mínimo o Nulo

La mayoría de los sistemas de IA entran en esta categoría, ya que no representan un riesgo significativo para los derechos fundamentales, la seguridad o la salud de las personas. Estos sistemas no están sujetos a obligaciones específicas bajo el RIA y su uso es libre. Ejemplos incluyen:

- Videojuegos habilitados para IA: Sistemas que mejoran la experiencia de juego sin implicaciones significativas para los usuarios.

- Filtros de spam: IA que clasifica y filtra correos electrónicos no deseados.

Aunque no se requieren medidas específicas para estos sistemas, se fomenta la adopción voluntaria de códigos de conducta y buenas prácticas para garantizar un desarrollo y uso ético de la IA.

En resumen, el Reglamento de Inteligencia Artificial de la Unión Europea establece un enfoque basado en el riesgo para regular el desarrollo y uso de sistemas de IA, asegurando que se maximicen los beneficios de esta tecnología mientras se protegen los derechos y la seguridad de los ciudadanos.

Leer el Reglamento completo aquí: https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX%3A32024R1689