La computación cuántica pertenece un metafórico país de máquinas que todavía no son máquinas, de promesas que se sostienen en ecuaciones tan frágiles como una mariposa sobre un hilo de cobre. Y, sin embargo, pocas infraestructuras concentran tanta expectativa científica, tanta inquietud política y tanta ambición económica. Es un campo que parece escrito en futuro, aunque sus raíces están clavadas en los años ochenta, cuando unos pocos físicos comprendieron que los ordenadores clásicos —por potentes que fueran— nunca podrían imitar la complejidad cuántica de la naturaleza. La teoría cuántica sostiene que el observador de un hecho influye en la manera en que ese hecho es percibido. Es probable que los ordenadores cuánticos de alto rendimiento que buscamos tarden una década o más en materializarse; no aparecerán de manera inmediata.

La intuición fue sencilla y radical: si el mundo fundamental es cuántico, quizás el cálculo también deba serlo. Ese golpe de pensamiento inauguró un linaje que pasa por simuladores cuánticos concebidos para imitar moléculas rebeldes, por definiciones formales de máquinas universales capaces de manipular la superposición y el entrelazamiento, y por algoritmos que, sobre el papel, superaban a cualquier estrategia clásica conocida. Aquel germen teórico no fue un sueño extravagante: era la respuesta inevitable a las limitaciones de los ordenadores convencionales. Algo así como admitir que el universo no puede comprimirse sin romper el cristal de la lógica tradicional.

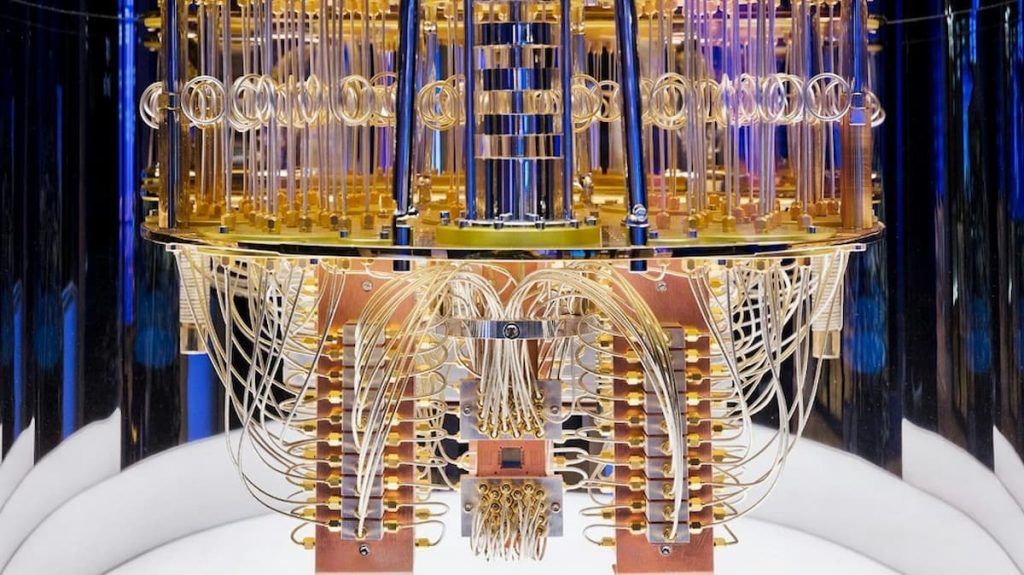

Con el tiempo, las ideas se convirtieron en dispositivos: qubits superconductores suspendidos en refrigeradores que rozan el cero absoluto, iones atrapados mediante campos electromagnéticos que no se ven pero gobiernan la posición de cada átomo, fotones que se desplazan por circuitos ópticos con una obediencia que solo la luz conoce. Cada tecnología es un intento distinto de domesticar lo indomesticable: mantener la coherencia cuántica, esa delicadeza que se destruye al menor roce del entorno. El enemigo de estas máquinas no es la complejidad, sino el ruido, la vibración mínima, el calor residual, incluso la mirada demasiado cercana. Construir un ordenador cuántico es, en realidad, construir un santuario donde el mundo clásico quede excluido.

El avance ha sido desigual, pero constante. Qubits cada vez más estables, puertas lógicas con menor error, chips tridimensionales que permiten densidades antes impensables, sistemas híbridos que mezclan fotónica con superconductores. Y en paralelo, una proliferación de algoritmos que aspiran a algo más que presumir en revistas científicas: resolver problemas químicos, simular materiales, optimizar redes logísticas, descifrar patrones que dejan perplejos incluso a los superordenadores más agresivos. Pero entre la euforia y la aplicación real todavía se abre un desfiladero: el de la corrección de errores cuánticos. En las máquinas actuales, cada operación es un acto de equilibrio sobre un hilo que tiembla. Para construir un dispositivo verdaderamente útil, sería necesario un ejército de qubits físicos protegiendo cada qubit lógico, un andamiaje monumental que requiere mejoras técnicas aún en desarrollo.

Por eso hablamos de una era intermedia, como si la tecnología caminara sobre una frontera movediza. Son máquinas ruidosas, pero suficientemente funcionales como para insinuar el porvenir. No son todavía la herramienta universal que muchos imaginan, pero tampoco son artefactos experimentales irrelevantes. En este escenario ambiguo se cargan expectativas gigantescas: desde diseñar nuevos fármacos mediante simulación molecular hasta reescribir los cimientos mismos de la criptografía contemporánea.

La amenaza criptográfica no necesita ser sensacionalista para resultar inquietante. Los sistemas que protegen la comunicación global —transacciones bancarias, datos gubernamentales, archivos médicos, redes diplomáticas— se sostienen en problemas matemáticos que un ordenador cuántico, en condiciones ideales, podría resolver con una eficacia devastadora. Aunque ese dispositivo aún no existe, los gobiernos y las empresas ya han comenzado la carrera para actualizar sus sistemas de cifrado. No es paranoia: es anticipación. Hay actores que almacenan información hoy con la esperanza de descifrarla mañana cuando la tecnología lo permita. La pregunta ya no es si habrá que migrar hacia métodos resistentes a ataques cuánticos, sino cuándo y a qué coste.

Pero la dimensión ética va más allá de la criptografía. La computación cuántica es una tecnología intrínsecamente cara, dependiente de cadenas de suministro sensibles, de materiales complejos, de centros de fabricación de exquisita precisión y de personal extremadamente especializado. Esto produce una asimetría que no es solo económica, sino cultural y geopolítica. No todos los países pueden construir un refrigerador de dilución, desarrollar su propia fotónica integrada o fabricar chips superconductores con los niveles de pureza necesarios. El riesgo evidente es que los avances cuánticos se concentren en manos de unas pocas naciones y conglomerados, creando una nueva capa de dependencia tecnológica global.

Además, la opacidad de la propia tecnología —una opacidad natural, derivada de la física, pero también industrial— puede dificultar una evaluación pública real del poder que acumula. ¿Cómo auditar un algoritmo cuántico? ¿Cómo determinar si una empresa exagera su capacidad técnica o si un gobierno utiliza la tecnología para fines que escapan al escrutinio democrático? La computación cuántica invita a plantearnos no solo qué puede hacerse, sino quién decide qué se hace.

Y luego está el poder económico: inversiones multimillonarias, consultoras que proyectan mercados futuros de magnitudes descomunales, alianzas entre universidades, empresas tecnológicas y gobiernos. Se están creando corredores industriales, centros de fabricación especializados, programas nacionales de talento y arquitecturas híbridas que prometen acelerar la transición desde los prototipos hacia máquinas capaces de resolver problemas reales. Las empresas que lideren este proceso no solo obtendrán beneficios: definirán estándares, controlarán infraestructuras críticas y moldearán la manera en que se organiza la investigación científica de las próximas décadas.

Todo ello convierte a la computación cuántica en un territorio paradójico: una promesa que aún no ha cumplido la mayoría de sus promesas, un poder que existe más en el horizonte que en el presente, una herramienta cuyo impacto se intuye más que se contabiliza. Pero también un recordatorio de hasta qué punto la tecnología puede alterar las jerarquías del mundo. No es excesivo decir que quien domine la computación cuántica dominará, en parte, la arquitectura del futuro: desde los materiales que utilizaremos hasta la seguridad que nos protegerá, desde las redes energéticas hasta el diseño industrial.

Quizá por eso este campo genera tanto vértigo. Porque obliga a pensar el conocimiento como un riesgo y un privilegio, como una forma de poder y también de responsabilidad. La computación cuántica no es simplemente un avance técnico; es un espejo incómodo donde se reflejan nuestras prioridades, nuestras ansiedades y nuestras desigualdades. Si alguna vez llegamos a construir una máquina cuántica plenamente funcional, no será solo un triunfo de la ingeniería: será una prueba moral. Una prueba sobre cómo decidimos usar aquello que entendemos del mundo más profundo, ese mundo que vibra en superposiciones invisibles y que, por primera vez, intentamos gobernar.